T-Robotics

2019년 4월 13일 토요일

#44. KAIST에서 "대학 유죄"를 외치다: ART Lab의 도전

3월 22일 카이스트 전산학부에서 진행된 AI x Education 포럼의 발표 내용입니다.

대학은 과연 최적화된 교육을 제공하고 있을까요? 인공지능 기술을 배우려면 꼭 대학원에 가야 할까요?

이 영상을 보시면 제가 요즘 어떤 교육을 꿈꾸고 어떤 일들을 벌이고 있는지 아실 수 있을 것입니다.

인공지능/로보틱스 기술을 배우는 가장 쉬운 길, ART Lab 유튜브 채널의 구독, 좋아요 부탁드려요~!

https://www.youtube.com/channel/UCzypbmDj_kVPDW3qWlrEFjA

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

2019년 3월 7일 목요일

#43. "정확도 98%의 인공지능"이 거짓인 이유

작년 저는 KIST에 계신 선배님으로부터 자문을 요청 받았습니다. 학생이 너무 좋은 결과를 가지고 왔는데, 분명 뭐가 잘못된 것 같은데 한번 봐달라는 것이었습니다. 학생은 뇌파를 가지고 환자가 어떤 운동상태인지를 머신러닝으로 판단하고 있었는데, 정확도가 무려 95%가 넘었습니다.

저는 자신있게 얘기했죠. 이거 잘못된 거 맞다고... 도대체 뭐가 잘못 되었을까요?레벨 별로 저지르는 실수를 정리해 보았습니다. 결론부터 말씀 드리자면, 현실 성능에 가깝게 성능을 보여주는 test set을 갖는 것이 곧 그 연구실/기업의 실력입니다. 너무 결과가 좋게 나오면 꼭 나를 의심합시다ㅎㅎ

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

2019년 2월 13일 수요일

#42. 사진 속 글자 읽기, OCR (Optical Character Recognition)

카메라로 차량번호판을 인식하는 것은 이젠 너무나 당연한 기술이 되어 버렸죠?이렇게 사진 속에서 글자를 인식하는 기술을 OCR(optical character recognition)이라고 하는데요, 명함앱, 번역앱 등 정말 다양한 곳에서 쓰이는 기술이랍니다.

혹시 이 문제가 이미 해결 되었다고 생각할지 모르겠지만, 아직도 OCR엔 과제들이 많이 남아있습니다. 그리고 최근엔 이러한 과제들을 딥러닝을 이용해 해결하려 하고있죠. OCR은 text localization과 recognition의 복합 기술인데요, 이를 위해 이미지 인식과 음성 인식의 요소 기술들이 복합적으로 쓰이죠.

오늘은 OCR 리더보드 1등을 기록하셨던 이활석님의 DEVIEW 2018 발표자료를 바탕으로 OCR을 설명해보도록 하겠습니다.

[Link] 이활석, "Reading AI" at DEVIEW2018, https://deview.kr/2018/schedule/235

[Slides] https://www.slideshare.net/TerryTaewoongUm/a-brief-introduction-to-ocr-optical-character-recognition

[비디오]

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

2019년 1월 28일 월요일

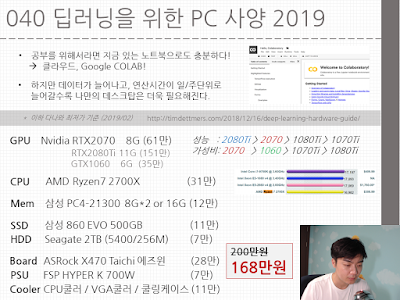

#40. 딥러닝을 위한 PC 사양 2019

안녕하세요. 괜히 공부가 안되니 '장비탓인가...' 싶은 생각이 드는 겨울입니다. 이럴 땐 질러야죠 ㅎㅎ

테리의 딥러닝토크에서 "딥러닝을 위한 하드웨어 구성"에 대해 이야기를 나눈 게 2년 전쯤이었는데요, 업데이트 할 필요가 느껴 (그리고 저도 컴퓨터 한 대를 사고 싶어서ㅠ) 다시 한번 정리하였습니다.

공부가 안되는 건 다 장비가 안좋아서 그런 겁니다. 새학기는 원래 학용품 새로 사고, 컴퓨터 새로 사야하는 시즌 아니겠습니까 ㅎㅎ 함께 질러보시죠 ㅋㅋ

[PC 사양 정리]

GPU : Nvidia RTX2070 8G (61만)

CPU : AMD Ryzen7 2700x (31만)

Mem : 삼성 PC4-21300 16G (12만)

SSD : 삼성 860 EVO 500G (11만)

HDD : 시게이트 2TB (7만)

메인보드 : ASRock x470 Taichi 에즈원 (28만)

PSU : FSP Hyper K 700W (7만)

기타 : CPU쿨러, VGA쿨러, 쿨링 케이스 (11만)

========

총 168만원

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

2018년 12월 1일 토요일

#39. 딥러닝 공부 가이드 2019 (무료 강의, 책)

테리가 추천하는 무료 딥러닝 공부자료들입니다.

딥러닝 토크 처음 시작할 때도 한번 추천한 바 있는데, 그게 벌써 2년 전이더라고요. 그 때 추천해드린 자료도 여전히 좋은 자료들인데요, 새로운 자료들도 좋은게 많아 2년 만에 2019년 버전으로 업데이트 하였습니다!

영상에서 소개하고 있는 무료 강좌 / 책 링크들은 다음과 같습니다.

(유튜브 위주로 올렸으나 사이트들도 있는 경우가 많으니 참고하세요)

[무료 강좌 - 섬머스쿨]

머신러닝 1시간으로 입문하기 (Terry) https://goo.gl/FoPe2c

Deep Learning & Reinforcement Learning Summer School

(2017) https://goo.gl/4WthXN

(2018) https://goo.gl/Z7stFe

Machine Learning Summer School (MPI) https://goo.gl/5hQtA1

[무료 강좌 - 한학기 강좌]

DeepLearning.ai (Andrew Ng) https://goo.gl/mMr4AW

CS231n (Stanford) https://goo.gl/WTLZkg

CS224d (Stanford) https://goo.gl/nmY6Ws

Fast.ai (Fast.ai) https://goo.gl/aBkesx

[무료 강좌 - 강화학습]

Deep RL bootcamp (UC Berkeley) https://goo.gl/i6CbtR

UCL lectures (DeepMind) https://goo.gl/gF7EoY

CS294 (UC Berkeley) https://goo.gl/d17a5x

[무료 강좌 - 한글]

모두의 딥러닝 (김성훈) https://goo.gl/zP6cYS

모두의 강화학습 (김성훈) https://goo.gl/XQiB9f

자연어 처리 (조경현) https://goo.gl/h8q6Kw

딥러닝 논문들 (최성준) https://goo.gl/7f2YyN

머신러닝 & 파이썬 (최성철, 유료) https://goo.gl/gy3U2y

[무료 책]

"Pattern Recognition and Machine Learning" https://goo.gl/EMbNKm

"The Element of Statistical Learning" https://goo.gl/Y8GqqG

"Gaussian Process for Machine Learning" https://goo.gl/4LU3Df

"Dive into Deep Learning" https://goo.gl/Bk5wF5

"Deep Learning" https://goo.gl/4kVPrm

"Machine Learning: a Probabilistic Perspective" (유료)

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

딥러닝 토크 처음 시작할 때도 한번 추천한 바 있는데, 그게 벌써 2년 전이더라고요. 그 때 추천해드린 자료도 여전히 좋은 자료들인데요, 새로운 자료들도 좋은게 많아 2년 만에 2019년 버전으로 업데이트 하였습니다!

영상에서 소개하고 있는 무료 강좌 / 책 링크들은 다음과 같습니다.

(유튜브 위주로 올렸으나 사이트들도 있는 경우가 많으니 참고하세요)

[무료 강좌 - 섬머스쿨]

머신러닝 1시간으로 입문하기 (Terry) https://goo.gl/FoPe2c

Deep Learning & Reinforcement Learning Summer School

(2017) https://goo.gl/4WthXN

(2018) https://goo.gl/Z7stFe

Machine Learning Summer School (MPI) https://goo.gl/5hQtA1

[무료 강좌 - 한학기 강좌]

DeepLearning.ai (Andrew Ng) https://goo.gl/mMr4AW

CS231n (Stanford) https://goo.gl/WTLZkg

CS224d (Stanford) https://goo.gl/nmY6Ws

Fast.ai (Fast.ai) https://goo.gl/aBkesx

[무료 강좌 - 강화학습]

Deep RL bootcamp (UC Berkeley) https://goo.gl/i6CbtR

UCL lectures (DeepMind) https://goo.gl/gF7EoY

CS294 (UC Berkeley) https://goo.gl/d17a5x

[무료 강좌 - 한글]

모두의 딥러닝 (김성훈) https://goo.gl/zP6cYS

모두의 강화학습 (김성훈) https://goo.gl/XQiB9f

자연어 처리 (조경현) https://goo.gl/h8q6Kw

딥러닝 논문들 (최성준) https://goo.gl/7f2YyN

머신러닝 & 파이썬 (최성철, 유료) https://goo.gl/gy3U2y

[무료 책]

"Pattern Recognition and Machine Learning" https://goo.gl/EMbNKm

"The Element of Statistical Learning" https://goo.gl/Y8GqqG

"Gaussian Process for Machine Learning" https://goo.gl/4LU3Df

"Dive into Deep Learning" https://goo.gl/Bk5wF5

"Deep Learning" https://goo.gl/4kVPrm

"Machine Learning: a Probabilistic Perspective" (유료)

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

2018년 11월 8일 목요일

#38. 딥러닝의 실제문제 적용, 레이블이 전부다

연구든 비지니스든, 실제 데이터에 딥러닝을 적용하시는 분들이라면 아마 supervised learning을 먼저 고려하셔야 할텐데요, 최대한 데이터를 빨리 모은 후 여러 최신 딥러닝 모델들을 적용하고 싶으시겠죠.

그런데 저는 다시한번 데이터 그 자체에 집중하셔야 한다고 말씀드리고 싶습니다. 왜냐면 좋은 데이터를 이기는 머신러닝 모델은 없거든요.

이 영상의 주제는 다음과 같습니다.

- 좋은 레이블을 이기는 머신러닝 모델은 없다.

- supervised learning은 invariance를 배우는 과정이다.

- 말로 표현할 수 있다면 최대한 그것을 적용하는 것이 데이터 효율을 높인다.

- 좋은 domain-knolwedge를 통해 annotation 알고리즘을 만들고, 그것을 통해 labeled dataset을 얻을텐데, 그래도 데이터는 한땀한땀 점검을 해야한다.

그럼 즐겁게 들어주세요 ^^

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

그런데 저는 다시한번 데이터 그 자체에 집중하셔야 한다고 말씀드리고 싶습니다. 왜냐면 좋은 데이터를 이기는 머신러닝 모델은 없거든요.

이 영상의 주제는 다음과 같습니다.

- 좋은 레이블을 이기는 머신러닝 모델은 없다.

- supervised learning은 invariance를 배우는 과정이다.

- 말로 표현할 수 있다면 최대한 그것을 적용하는 것이 데이터 효율을 높인다.

- 좋은 domain-knolwedge를 통해 annotation 알고리즘을 만들고, 그것을 통해 labeled dataset을 얻을텐데, 그래도 데이터는 한땀한땀 점검을 해야한다.

그럼 즐겁게 들어주세요 ^^

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

2018년 9월 29일 토요일

# 37. GIST 레이드랩에서 진행한 5분 잡썰

"저 딥러닝 강좌도 다 봤고 시중에 나온 책도 다 봤는데 그 다음엔 뭘 해야하죠? 뭔가 아는 것 같으면서도 딥러닝을 잘 모르고 있는 것 같아요."

많은 분들이 딥러닝 튜토리얼 레벨의 학습을 마친 후 무엇을 공부해야 하는지 질문을 하십니다. 아마도 다음 타겟은 튜토리얼 속 문제가 아닌 real-world problem에 도전하는 것이겠죠?

하지만 real-world problem을 다루는 머신러닝 연구자/개발자는 튜토리얼에선 볼 수 없었던 많은 문제에 부딪치게 됩니다. 어쩌면 '뭐야.. 내가 현재 하고있는 일의 90%는 튜토리얼에서 중요하다고 언급도 안했던 내용들이잖아'라며 느끼실지도 모릅니다.

과연 튜토리얼 밖 실제문제에 딥러닝을 적용할 땐 어떤 이슈들을 맞이하게 될까요? 오랜만에 돌아온 테리의 딥러닝톡, 즐겁게 들어주세요 :)

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

많은 분들이 딥러닝 튜토리얼 레벨의 학습을 마친 후 무엇을 공부해야 하는지 질문을 하십니다. 아마도 다음 타겟은 튜토리얼 속 문제가 아닌 real-world problem에 도전하는 것이겠죠?

하지만 real-world problem을 다루는 머신러닝 연구자/개발자는 튜토리얼에선 볼 수 없었던 많은 문제에 부딪치게 됩니다. 어쩌면 '뭐야.. 내가 현재 하고있는 일의 90%는 튜토리얼에서 중요하다고 언급도 안했던 내용들이잖아'라며 느끼실지도 모릅니다.

과연 튜토리얼 밖 실제문제에 딥러닝을 적용할 땐 어떤 이슈들을 맞이하게 될까요? 오랜만에 돌아온 테리의 딥러닝톡, 즐겁게 들어주세요 :)

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

2018년 9월 20일 목요일

#36. 딥러닝의 실제적용, 튜토리얼과 무엇이 다른가?

"저 딥러닝 강좌도 다 봤고 시중에 나온 책도 다 봤는데 그 다음엔 뭘 해야하죠? 뭔가 아는 것 같으면서도 딥러닝을 잘 모르고 있는 것 같아요."

많은 분들이 딥러닝 튜토리얼 레벨의 학습을 마친 후 무엇을 공부해야 하는지 질문을 하십니다. 아마도 다음 타겟은 튜토리얼 속 문제가 아닌 real-world problem에 도전하는 것이겠죠?

하지만 real-world problem을 다루는 머신러닝 연구자/개발자는 튜토리얼에선 볼 수 없었던 많은 문제에 부딪치게 됩니다. 어쩌면 '뭐야.. 내가 현재 하고있는 일의 90%는 튜토리얼에서 중요하다고 언급도 안했던 내용들이잖아'라며 느끼실지도 모릅니다.

과연 튜토리얼 밖 실제문제에 딥러닝을 적용할 땐 어떤 이슈들을 맞이하게 될까요? 오랜만에 돌아온 테리의 딥러닝톡, 즐겁게 들어주세요 :)

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

많은 분들이 딥러닝 튜토리얼 레벨의 학습을 마친 후 무엇을 공부해야 하는지 질문을 하십니다. 아마도 다음 타겟은 튜토리얼 속 문제가 아닌 real-world problem에 도전하는 것이겠죠?

하지만 real-world problem을 다루는 머신러닝 연구자/개발자는 튜토리얼에선 볼 수 없었던 많은 문제에 부딪치게 됩니다. 어쩌면 '뭐야.. 내가 현재 하고있는 일의 90%는 튜토리얼에서 중요하다고 언급도 안했던 내용들이잖아'라며 느끼실지도 모릅니다.

과연 튜토리얼 밖 실제문제에 딥러닝을 적용할 땐 어떤 이슈들을 맞이하게 될까요? 오랜만에 돌아온 테리의 딥러닝톡, 즐겁게 들어주세요 :)

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

2018년 5월 21일 월요일

#35. Deep Variational Bayes Filters (2017)

seqeunce나 time-series 데이터엔 RNN이나 LSTM이 참 효과적이죠? 하지만 그것만으로는 불만족스럽다고 하네요. "What's wrong with RNN?"

사실 비슷한 질문을 한적이 있었죠. "Autoencoder가 있는데 Variational Autoencoder는 도대체 왜 있는거죠?" 핵심은 Latent space에 있습니다. 사실 우리는 prediction만을 내뱉는걸 원하지 않고, 확률분포를 알기를 바라며, 더 정확히는 observation을 만들어내는 데이터가 "진짜로" 살고 있는 공간, latent space를 찾길 바라는거죠.

무슨 얘기냐고요? 이 발표를 들으시면 조금은 감이 잡히시지 않을까 싶습니다. VAE를 timeseries에 확장한, 혹은 칼만필터에 딥러닝을 첨가한 "Deep Variational Bayes Filters (2017)"이란 논문입니다.

"Deep Variational Bayes Filters: Unsupervised Learning of State Space Models from Raw Data", ICLR2017.

[Link] https://arxiv.org/abs/1605.06432

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

사실 비슷한 질문을 한적이 있었죠. "Autoencoder가 있는데 Variational Autoencoder는 도대체 왜 있는거죠?" 핵심은 Latent space에 있습니다. 사실 우리는 prediction만을 내뱉는걸 원하지 않고, 확률분포를 알기를 바라며, 더 정확히는 observation을 만들어내는 데이터가 "진짜로" 살고 있는 공간, latent space를 찾길 바라는거죠.

무슨 얘기냐고요? 이 발표를 들으시면 조금은 감이 잡히시지 않을까 싶습니다. VAE를 timeseries에 확장한, 혹은 칼만필터에 딥러닝을 첨가한 "Deep Variational Bayes Filters (2017)"이란 논문입니다.

"Deep Variational Bayes Filters: Unsupervised Learning of State Space Models from Raw Data", ICLR2017.

[Link] https://arxiv.org/abs/1605.06432

[비디오]

[슬라이드]

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

2018년 4월 13일 금요일

#34. KL divergence, 순서가 중요할까요?

Kullback-Leibler Divergence (쿨벡-라이블러 다이버전스, 혹은 KL divergence) 많이 써보셨죠? 두개의 확률분포가 있을 때 둘 사이의 차이를 측정해주는 용도로 많이 쓰는데요, 아마 'KL Divergence는 거리처럼 쓰이지만 거리는 아니다'라는 얘기도 많이 들어보셨을 겁니다.

이유는 두 분포의 순서 중 어떤 것을 먼저 넣느냐에 따라 나오는 값이 달라지기 때문인데요, 즉 KL(P,Q) != KL(Q,P)라는거죠. 그렇다면... P(X)를 true, Q(X)를 predicted라고 했을 때 어떤 값을 먼저 넣어서 거리를 재야할까요? 순서에 따라 물리적 의미의 차이가 있을까요? 오늘은 KL-divergence에 대해 더 깊이 알아보았습니다.

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

이유는 두 분포의 순서 중 어떤 것을 먼저 넣느냐에 따라 나오는 값이 달라지기 때문인데요, 즉 KL(P,Q) != KL(Q,P)라는거죠. 그렇다면... P(X)를 true, Q(X)를 predicted라고 했을 때 어떤 값을 먼저 넣어서 거리를 재야할까요? 순서에 따라 물리적 의미의 차이가 있을까요? 오늘은 KL-divergence에 대해 더 깊이 알아보았습니다.

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

2018년 3월 25일 일요일

#33. On Calibration of Modern Neural Networks

딥러닝으로 classification을 하면 "클래스 확률"이라 믿어지는 softmax 아웃풋이 나오죠? 하지만 아웃풋 노드값이 0.9가 나왔다고해서, 그것이 90% 확률로 맞을 가능성이 있다는 뜻은 아니랍니다. 그렇다면 0.9가 실제 "90% 정확도"를 표현하게 만들려면 어떻게 해야할까요?

이러한 주제를 calibration이라고 하는데요, 이번에 PR-12 논문읽기 모임에서 발표한 "On Calibration of Modern Neural Networks"이란 논문은 단순히 상수로 나눠주는 것만으로 이 문제를 간단하게 해결하였습니다. 논문의 내용도 흥미롭지만, 문제를 설정하고 풀어나가는 과정도 연구자로서 볼만하네요. 그럼 즐겁게 들어주세요 ^^

이러한 주제를 calibration이라고 하는데요, 이번에 PR-12 논문읽기 모임에서 발표한 "On Calibration of Modern Neural Networks"이란 논문은 단순히 상수로 나눠주는 것만으로 이 문제를 간단하게 해결하였습니다. 논문의 내용도 흥미롭지만, 문제를 설정하고 풀어나가는 과정도 연구자로서 볼만하네요. 그럼 즐겁게 들어주세요 ^^

2018년 2월 16일 금요일

#32. PCA의 이해

PCA라고 들어보셨나요? 보통 차원축소(dimensionality reduction)나 시각화(visualization), 그리고 특징 추출(feature extraction)을 할 때 많이 쓰는 방법인데요, 사실 PCA는 모든 dimensionality reduction 기법들의 기본이자 선형대수의 종합일 정도로 너무나 중요하고 꼭 숙지해야 할 기법입니다. 아름다울 뿐만 아니라 실용적이기도 하고요.

그래서 오늘은 PCA를 "수식없이" 살펴봤습니다. 내용이 중요하다보니 이야기가 좀 길어졌네요ㅎㅎ 영상을 보고 PCA에 대해 더 알아보실 분들은 저의 옛 블로그를 참고하시거나, 더 좋은 방법은 영어로 된 튜토리얼 문서를 한번 꼭 읽어보세요!

[Link] "PCA의 의미와 한계점" https://www.facebook.com/TRobotics/posts/796663103771140

[Link] "A Tutorial on PCA", Jonathon Shlens, https://arxiv.org/abs/1404.1100

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

그래서 오늘은 PCA를 "수식없이" 살펴봤습니다. 내용이 중요하다보니 이야기가 좀 길어졌네요ㅎㅎ 영상을 보고 PCA에 대해 더 알아보실 분들은 저의 옛 블로그를 참고하시거나, 더 좋은 방법은 영어로 된 튜토리얼 문서를 한번 꼭 읽어보세요!

[Link] "PCA의 의미와 한계점" https://www.facebook.com/TRobotics/posts/796663103771140

[Link] "A Tutorial on PCA", Jonathon Shlens, https://arxiv.org/abs/1404.1100

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

2018년 1월 28일 일요일

#31. Deep Learning: A Critical Appraisal

이번에 리뷰한 논문은 논문이라기보단 칼럼에 가까운 글입니다. 딥러닝과 현재 딥러닝 연구들의 한계점들에 대해 이야기한 "Deep learning: A critical appraisal"이란 논문인데요, "왜 딥러닝을 이용해야하는가?", "딥러닝이 잘하는 것은 무엇이고 못하는 것은 무엇인가?", "인공지능은 얼마나 멀리있는가?" 등에 대해 이야기하려면 꼭 짚어봐야하는 내용들이죠.

2017년 10월 28일 토요일

#30. ROC 커브 (+ AUC, Precision, Recall)

Accuracy가 성능을 나타내는 전부는 아니란거 다들 알고 계시죠? 지난번엔 암환자 진단의 예를 통해 accuracy의 함정을 알아보고, precision과 recall에 대해서 설명을 했는데요,

이번에는 이와 함께 많이 쓰이는 개념 중 하나인 ROC curve에 대해서 알아보았습니다. 특히 메디컬 페이퍼에선 신뢰성 있는 판단을 위해 ROC를 많이 이용하는데요, ROC란 무엇이고 도대체 왜 쓰는 것일까요? ROC에 대해 한번 알아보시죠.

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

이번에는 이와 함께 많이 쓰이는 개념 중 하나인 ROC curve에 대해서 알아보았습니다. 특히 메디컬 페이퍼에선 신뢰성 있는 판단을 위해 ROC를 많이 이용하는데요, ROC란 무엇이고 도대체 왜 쓰는 것일까요? ROC에 대해 한번 알아보시죠.

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

2017년 9월 13일 수요일

#29. Tensorflow vs. PyTorch

딥러닝 공부를 시작하시는 분들의 큰 고민 중 하나가 짜장면이냐 짬뽕이냐가 아니라 Tensorflow냐 Pytorch냐일텐데요, 두가지를 가볍게 비교해 보았습니다. 결론은? 뭐든 그냥 손에 착 달라붙고 좀더 끌리는걸 하세요~ 저는 개인적으로 무엇을 선택했을까요...?^^

[Reference] "PyTorch vs Tensorflow" https://medium.com/towards-data-science/pytorch-vs-tensorflow-spotting-the-difference-25c75777377b

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

[Reference] "PyTorch vs Tensorflow" https://medium.com/towards-data-science/pytorch-vs-tensorflow-spotting-the-difference-25c75777377b

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

2017년 9월 10일 일요일

#28. Understanding Black-box Predictions via Influence Functions

Tensorflow KR에서 진행하고 있는 논문읽기 모임 PR12에서 발표한 저의 네번째 발표입니다. 이번에는 ICML2017에서 베스트페이퍼상을 받은 "딥러닝의 결과를 어떻게 이해할 수 있는가"에 대한 논문을 리뷰해보았습니다.

딥러닝은 성능은 좋지만 왜 그게 잘되는지 모르는, 그야말로 "블랙박스"와 같은 모델인데요, 이 논문에서는 '만약 A라는 트레이닝 데이터가 없다면 어떤 변화가 일어날까?', 'B라는 테스트 이미지에 가장 결정적인 영향을 주는 트레이닝 데이터는 무엇일까?'와 같은 질문에 대해 influence function이라는 것을 도입해서 해결하려 하였습니다.

"Understanding Black-box Predictions via Influence Functions", Pang Wei Koh and Percy Liang, 2017

[Link] http://proceedings.mlr.press/v70/koh17a.html

[YouTube] https://www.youtube.com/watch?v=xlmlY8WHjkU&index=30&list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[Slides] https://www.slideshare.net/secret/1Bqa2zTPde1Uc4

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

딥러닝은 성능은 좋지만 왜 그게 잘되는지 모르는, 그야말로 "블랙박스"와 같은 모델인데요, 이 논문에서는 '만약 A라는 트레이닝 데이터가 없다면 어떤 변화가 일어날까?', 'B라는 테스트 이미지에 가장 결정적인 영향을 주는 트레이닝 데이터는 무엇일까?'와 같은 질문에 대해 influence function이라는 것을 도입해서 해결하려 하였습니다.

"Understanding Black-box Predictions via Influence Functions", Pang Wei Koh and Percy Liang, 2017

[Link] http://proceedings.mlr.press/v70/koh17a.html

[YouTube] https://www.youtube.com/watch?v=xlmlY8WHjkU&index=30&list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[Slides] https://www.slideshare.net/secret/1Bqa2zTPde1Uc4

[비디오]

[슬라이드]

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq

[facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook

2017년 8월 13일 일요일

#27. Cross entropy와 KL divergence

혹시 "classification을 위해 cross-entropy를 loss function으로 사용합니다" 라든지, "분포의 차이를 줄이기 위해 KL-divergence를 최소화시킵니다"와 같은 이야기를 들어보신 적 있으신가요?

정보의 양을 따질 때, 혹은 확률 분포들의 차이를 따질 때 중요하게 사용되는 개념 중 하나가 바로 Entropy인데요, 오늘은 엔트로피란 무엇인지에 대해 쉬운 예제와 함께 살펴봤습니다.

결론을 말씀드리자면 "엔트로피는 정보를 최적으로 인코딩하기 위해 필요한 bit수이며, 각 label들의 확률 분포의 함수"입니다.

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq [facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

2017년 8월 5일 토요일

#26. 정보량을 나타내는 엔트로피 (Entropy)

혹시 "classification을 위해 cross-entropy를 loss function으로 사용합니다" 라든지, "분포의 차이를 줄이기 위해 KL-divergence를 최소화시킵니다"와 같은 이야기를 들어보신 적 있으신가요?

정보의 양을 따질 때, 혹은 확률 분포들의 차이를 따질 때 중요하게 사용되는 개념 중 하나가 바로 Entropy인데요, 오늘은 엔트로피란 무엇인지에 대해 쉬운 예제와 함께 살펴봤습니다.

결론을 말씀드리자면 "엔트로피는 정보를 최적으로 인코딩하기 위해 필요한 bit수이며, 각 label들의 확률 분포의 함수"입니다.

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq [facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

2017년 7월 23일 일요일

#25. Learning with side information through modality hallucination (2016)

Tensorflow KR에서 진행하고 있는 논문읽기 모임 PR12에서 발표한 저의 세번째 발표입니다. 이번에는 "다양한 재료들을 어떻게 학습에 사용할 수 있을까"에 대한 내용을 발표하였습니다.

전형적인 supervised learning setting에선 이미지와 레이블을 주고 그것의 매핑을 학습하는데요, 사실 이미지 말고도 우리가 줄 수 있는 정보가 더 많을 수도 있습니다. 예를 들면 Kinect를 이용한 depth image 처럼 말이죠.

하지만 문제는 depth image를 가지고 트레이닝을 할 경우 테스트 때 (런타임 때)도 depth image가 있어야지 prediction이 가능하다는 단점이 있습니다. 있는 재료를 활용하려다 더 불편함만 얻게되는 결과지요. 근데 그렇다고 트레이닝 때 더 있는 재료를 활용 안하는 것도 최선은 아닌 것 같고요...

이 논문은 이처럼 트레이닝 때 이용한 modality(인풋 소스)가 테스트 때는 모두 이용할 수 없을 때 이것을 할루시네이션처럼 "복사"함으로써 해결하는 방법을 제시했습니다. 수학도 없고 들어보시면 재밌으실 겁니다 ㅎㅎ 그럼 즐겁게 들어주세요~

"Learning with side information through modality hallucination", J. Hoffman et al., 2017.

[Link] http://www.cv-foundation.org/openaccess/content_cvpr_2016/html/Hoffman_Learning_With_Side_CVPR_2016_paper.html

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

전형적인 supervised learning setting에선 이미지와 레이블을 주고 그것의 매핑을 학습하는데요, 사실 이미지 말고도 우리가 줄 수 있는 정보가 더 많을 수도 있습니다. 예를 들면 Kinect를 이용한 depth image 처럼 말이죠.

하지만 문제는 depth image를 가지고 트레이닝을 할 경우 테스트 때 (런타임 때)도 depth image가 있어야지 prediction이 가능하다는 단점이 있습니다. 있는 재료를 활용하려다 더 불편함만 얻게되는 결과지요. 근데 그렇다고 트레이닝 때 더 있는 재료를 활용 안하는 것도 최선은 아닌 것 같고요...

이 논문은 이처럼 트레이닝 때 이용한 modality(인풋 소스)가 테스트 때는 모두 이용할 수 없을 때 이것을 할루시네이션처럼 "복사"함으로써 해결하는 방법을 제시했습니다. 수학도 없고 들어보시면 재밌으실 겁니다 ㅎㅎ 그럼 즐겁게 들어주세요~

"Learning with side information through modality hallucination", J. Hoffman et al., 2017.

[Link] http://www.cv-foundation.org/openaccess/content_cvpr_2016/html/Hoffman_Learning_With_Side_CVPR_2016_paper.html

[비디오]

[슬라이드]

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

2017년 7월 8일 토요일

#24. Intra- / Inter-Class Variability

여러분들이 만약 classification(분류)을 머신러닝을 통해 하고싶다면, 그냥 데이터만 다 때려넣고 머신러닝을 돌리면 될까요? 아마도 데이터의 질에 따라 될 수도 있고, 안될 수도 있을텐데요, 그렇다면 데이터의 '질'이란 과연 무엇일까요?

Classification에서 나의 데이터 혹은 나의 피쳐의 상태를 가장 잘 표현해주는 단어는 아마도 '클래스 내부의 분산이 어떠냐(intra-class variability)', 그리고 '클래스 간 분신이 어떠냐(inter-class variability)'일 것입니다. 이게 뭐냐고요? 영상을 보시죠 ^^

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq [facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

Classification에서 나의 데이터 혹은 나의 피쳐의 상태를 가장 잘 표현해주는 단어는 아마도 '클래스 내부의 분산이 어떠냐(intra-class variability)', 그리고 '클래스 간 분신이 어떠냐(inter-class variability)'일 것입니다. 이게 뭐냐고요? 영상을 보시죠 ^^

* 테리의 딥러닝 토크

[youtube] https://www.youtube.com/playlist?list=PL0oFI08O71gKEXITQ7OG2SCCXkrtid7Fq [facebook] https://www.facebook.com/deeplearningtalk/

* T-Robotics의 글은 facebook과 rss reader로도 받아보실 수 있습니다.

[facebook] http://facebook.com/trobotics

[rss] http://t-robotics.blogspot.kr/feeds/posts/default

피드 구독하기:

덧글 (Atom)